Le innovazioni tecnologiche sono sicuramente una delle caratteristiche del ventunesimo secolo. Dalla realtà aumentata alla blockchain, sono centinaia le innovazioni che, negli ultimi anni, hanno modificato radicalmente le nostre abitudini quotidiane. Nonostante l’intelligenza artificiale sia nata negli anni Cinquanta, negli ultimi anni abbiamo assistito a un continuo avanzamento di questo sistema che, oggi, abbonda di innovazione e controversie. I nuovi sviluppi dell’intelligenza artificiale, inoltre, mettono a rischio la nostra privacy.

Le basi dell’intelligenza artificiale

È indubbio che l’intelligenza artificiale abbia rivoluzionato la tecnologia e l’informatica. In un’ottica industriale, l’intelligenza artificiale permette una continua produzione senza cali di produttività. In ottica statistica, permette di analizzare centinaia di migliaia di dati in poco tempo. Eppure attorno all’intelligenza artificiale vi è un forte dibattito etico che, sebbene sia principalmente accademico e possa sembrare lontano dalla nostra quotidianità, non deve essere ignorato.

Ma partiamo dalle basi: l’intelligenza artificiale come la conosciamo oggi è nata grazie a un gruppo ristretto di scienziati che ha alla base Alan Turing. Uno dei primi campi di applicazione dell’intelligenza artificiale è stato il gioco degli scacchi, ritenuto come una valida misura per valutare l’effettivo funzionamento del programma informatico. Gli scienziati che hanno lavorato allo sviluppo dell’intelligenza artificiale erano sicuramente consapevoli dell’impatto che il loro lavoro avrebbe avuto, ma non potevano immaginare quanto velocemente si sarebbe diffuso e approfondito.

Ad oggi, nonostante i progressi, la situazione non è tanto diversa da quella degli anni Cinquanta: piccoli gruppi di scienziati, informatici e ingegneri creano software di intelligenza artificiale che verranno usati da milioni di persone. Piccoli gruppi di persone, quindi, influenzano l’intero mondo. È proprio da qui che iniziano le controversie.

Controversie ed etica in uno dei dibattiti fondamentali del nostro secolo

Le controversie riguardo l’intelligenza artificiale sono molteplici e spesso complicate da sviscerare. È fondamentale, innanzitutto, capire che l’intelligenza artificiale non è da considerarsi imparziale. I software funzionano sulla base di algoritmi e dati che sono scritti da persone umane. Questo li rende frutto di pregiudizi, preconcetti, errori e convinzioni umani.

Facciamo un esempio e ipotizziamo un software per creare una mappa della criminalità di una città. Affinché possa funzionare, al software saranno forniti dati sui crimini commessi nella città per individuare le zone più a rischio. I dati però non sono imparziali, perché derivati da azioni umane: se si presume che in certe zone potrebbero esserci criminali, la polizia farà più controlli e aumenteranno gli arresti; allo stesso modo, in zone ritenute tranquille non farà controlli e non arresterà nessuno. In questo modo i dati saranno già distorti dalle convinzioni umane che portano la polizia a posizionarsi in certi punti e non in altri. La base algoritmica di partenza dell’intelligenza artificiale è, sin dal principio, frutto di un pregiudizio involontario.

A questo è da aggiungersi che l’input dato al software di intelligenza artificiale e al machine learning è basato sulle conoscenze di chi lo crea e che, una volta avviata, l’intelligenza artificiale apprende e imita i comportamenti umani.

Mettendo insieme queste prime informazioni, si evince sin da subito quanto l’intelligenza artificiale possa essere problematica: l’intelligenza artificiale potrebbe essere – ed è – un vettore tramite cui si diffondono discriminazioni e pregiudizi.

Leggi anche: Intelligenza artificiale: un po’ di chiarezza.

In secondo luogo gli studiosi pongono l’attenzione sulla mancanza di responsabilità. Questa mancanza si sviluppa su un duplice fronte. Da un lato, gli algoritmi sono definiti come scatole nere: l’intelligenza artificiale fornisce un risultato sulla base dell’input che abbiamo dato, ma non si sa come si è arrivati a questo risultato. Nemmeno chi crea gli algoritmi lo sa. Se nessuno sa come effettivamente come questi codici funzionano, chi è responsabile degli errori che creano?

Dall’altro lato, sappiamo che le nuove tecnologie creano e usano infiniti dati. A chi appartengono questi dati? Questa forte asimmetria tra chi usa la tecnologia e chi effettivamente ne è padrone è fonte di forte preoccupazione.

Sorveglianza biometrica: la nuova frontiera dell’intelligenza artificiale

Vogliamo, quindi, dire che l’intelligenza artificiale è il male e che dobbiamo smettere di utilizzarla? No, ma è necessaria una regolamentazione.

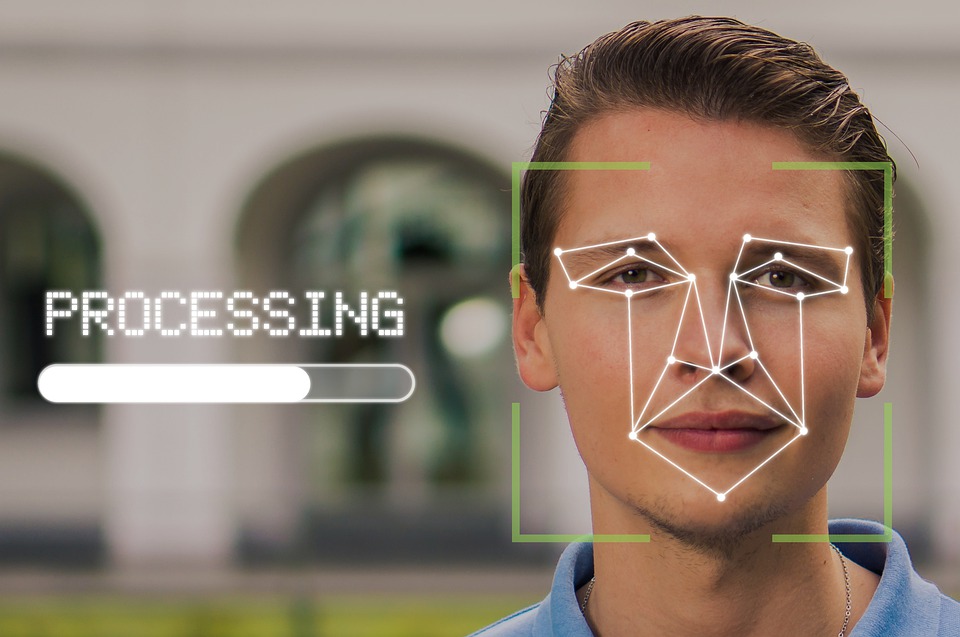

Negli ultimi anni un ramo dell’intelligenza artificiale si è dedicato allo sviluppo di software di riconoscimento facciale. Questo sistema, però, non si limita allo sblocco del telefono mostrandogli il nostro viso, ma vuole essere utilizzato a fini sorvegliativi.

Questi software, infatti, sarebbero utilizzati negli spazi pubblici e permetterebbero la scansione del viso di tutti i passanti. A tal proposito è nata la campagna Reclaim Your Face [Riprenditi la faccia, N.d.R] , in Italia supportata dal Centro Hermes per la trasparenza e i diritti umani digitali. La campagna ha l’obiettivo di bloccare i sistemi di video sorveglianza biometrica in Europa non solo per tutelare la privacy, in quanto ognuno di noi potrebbe essere trattato come un potenziale sospetto, ma anche per le incognite legate alla tecnologia stessa (come attacchi hacker e abusi delle autorità).

Privacy, errori e Clearview AI

Tra le molte vicende che si possono raccontare in merito, c’è quella della compagnia Clearview AI, che vende software di riconoscimento facciale alle forze di polizia e ad aziende private. Clearview AI basa “l’allenamento” dell’algoritmo di riconoscimento facciale su un database di milioni di foto prese, senza consenso degli interessati, dai social media. Come riportato in un’inchiesta di Wired, Clearview AI potrebbe avere un database di tre miliardi di immagini. Numerosi attivisti in tutto il mondo hanno denunciato la compagnia per la forte violazione della privacy dei cittadini e Clearview AI è anche contestata dal garante della privacy.

Queste violazioni della privacy si aggiungono a un discorso più ampio di discriminazioni insite nell’intelligenza artificiale. Come abbiamo detto in precedenza, l’intelligenza artificiale viene sviluppata da pochi individui che sono, per la maggior parte, uomini bianchi. Questa predominanza crea e replica una serie di discriminazioni nei confronti di persone di diverse etnie e genere. I software di riconoscimento facciale funzionano quasi perfettamente sui visi degli uomini, ma non altrettanto sui visi delle donne, dei neri, delle minoranze, dei bambini e degli anziani.

Nel 2015 fece scalpore il caso di Google Photos che con la funzione di etichettatura automatica delle foto, basata sull’intelligenza artificiale, etichettò la foto di due ragazzi neri con il tag “Gorilla”. Più recentemente, a settembre di quest’anno, lo stesso problema è stato riscontrato su Facebook.

Ecco allora che se mettiamo insieme tutte le informazioni, implementare un sistema di sorveglianza biometrica basato sull’intelligenza artificiale diventa pericoloso. Si tratterebbe di un’importante violazione della privacy di ognuno di noi e, al contempo, comporterebbe un aumento delle discriminazioni.

Recentemente Clearview AI ha anche dichiarato che il suo software sarà in grado di riconoscere i volti coperti da mascherina o non a fuoco. Con un sistema di riconoscimento facciale che si è già dimostrato fallace, questo nuovo sviluppo non potrà che avere conseguenze disastrose e tutti potremmo diventare potenziali sospetti a nostra insaputa.

La tutela europea

Fortunatamente, questo dibattito non è più solo accademico e anche l’Unione Europea ha iniziato a intavolare un discorso di regolamentazione dell’intelligenza artificiale. L’AI Act, questo il nome della proposta, sarebbe un atto rivoluzionario per regolare l’ampia gamma di materie e strumenti dell’intelligenza artificiale.

Proprio lo scorso 5 ottobre il Parlamento europeo ha espresso un voto storico, chiedendo il divieto permanente al riconoscimento automatico in spazi pubblici. Si aggiungono anche il divieto di utilizzo di banche dati private, come quella di Clearview AI, e una maggiore trasparenza degli algoritmi, in modo che questi possano essere tracciabili e documentati. Il voto del Parlamento europeo, arrivato con trecentosettantasette a favore, duecentoquarantotto contrari e sessantadue astenuti, dovrà essere replicato anche all’interno della Commissione. Con i partiti di destra e i popolari che sperano in un cambiamento di rotta da parte di quest’ultima, per il momento il voto parlamentare è una forte presa di posizione contro la sorveglianza di massa nel continente europeo.

Per capire cosa ne sarà della nostra privacy, del riconoscimento facciale e della regolamentazione dell’intelligenza artificiale, per ora, non ci resta che aspettare.